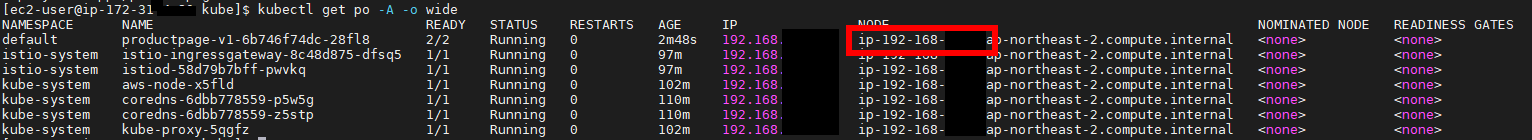

본 문서에서는 Istio를 이용한 Service Mesh 구성에서 Pod sidecar로 실행되는 Envoy에 대한 on-line config 방법에 대해서 공유한다. Istio 로 service mesh가 구성된 상태에서, 특정 pod의 sidecar로 떠있는 container에 접근하여 admin page에 접속하는 명령어는 아래와 같다. kubectl exec -it productpage-v1-6b746f74dc-28fl8 -c istio-proxy -- curl -X POST http://localhost:15000/ 또한, 위의 페이지를 호출하여 istio envoy 의 현재 설정값을 확인하거나 수정이 가능하다. 전체 path 목록은 아래의 명령어를 입력한다. kubectl exec -it pr..